|

|

МЕНЮ

|

Реферат: Теория вероятностейТакое множество F – называют алгебра событий. Вероятностью события А называют такую числовую функцию Р(А), определенную на алгебре событий F, для которой справедливы следующие аксиомы: 1. Для любого АЄF верно Р(А)≥0 – аксиома неотрицательности. 2. Р(Ω)=1 – аксиома нормированности. 3. Если АЄF и ВЄF несовместимы (то есть А∩В=Ө), то Р(АUВ)=Р(А)+Р(В) – аксиома аддитивности. 7. Формула Бейеса Пусть мы знаем вероятности событий А и В: Р(А) и Р(В). И пусть мы знаем условную вероятность события А по В: Р(A|B). Как найти условную вероятность P(B|A)? На этот вопрос отвечает формула Бейеса. Р(B|A)=P(A|B)·P(B)/P(A) (1) Разумеется этой формулой можно пользоваться только при условии, что Р(А)0. Формула Бейеса выводится из следующих равенств: Р(ВА)=Р(В|A)·P(A) (2) Р(AB)=Р(A|B)·P(B) (3) Р(ВА)=Р(AB) (4) так как пересечение событий В и А очевидно не зависит от порядка, в котором записаны А и В, т.е. ВА=AB. В случае Р(А)=0 принимаю обычно, что Р(В|A) есть величина неопределенная. 8.Формула полной вероятности. Пусть имеем полную

группу из n попарно непересекающихся событий

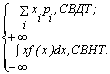

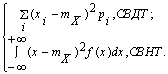

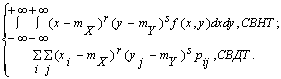

Пусть мы знаем условные вероятности некоторого события А по Еi: Р(А|Ei) и вероятности Р(Ei), i=1,...,n. Справедлива следующая формула полной вероятности для события А Р(А)=Р(A|E1)·P(E1)+...+P(A|En)·P(En) (7) Доказательство этой формулы вытекает из следующих равенств P(A)=P()=P(A(Ei))=P(AE1)+...+P(AEn)=Р(A|E1)·P(E1)+...+P(A|En)·P(En) (8) Из элементарной формулы Бейеса (1) и формулы полной вероятности (7) вытекает следующая более полная формула Бейеса Р(Еi|A)=P(A|Ei)·P(Ei)/(Р(A|E1)·P(E1)+...+P(A|En)·P(En)) (9) 8. Полная группа событий Несовместимые события – события, наступление которых одновременно при одном и том же опыте (испытании) невозможно. Например, выпадение двух граней кубика при одном броске невозможное событие. Полная группа событий – совокупность однородных несовместимых событий, наступление одного из которых обязательно. Для примера с игральным кубиком полная группа событий будет выпадение каждой из шести граней. И по классическому и по аксиоматическому определению вероятности очевидно, что вероятность наступления любого случайного события А будет равна 0<Р(А)<1. Краевые значения 0 и 1 будут определять неслучайные события – их делят на: невозможные – ( Р(А)=0 или Р(Ө)=0) – наступление которых при данных условиях невозможно достоверные – (Р(А)=1) – наступление которых при данных условиях обязательно. Для несовместимых событий легко определить вероятность объединения (суммы) событий. Если Аi при i Є (1, n) несовместимые события, то вероятность суммы событий Аi равна сумме их частных вероятностей. Р(А1+А2+,…,+Аn) = Р(А1)+Р(А2)+…+Р(Аn) 9. Независимость событий Событие А называется независимым от события В, если наступление события А не оказывает никакого влияния на вероятность наступления события В.Вероятность одновременного наступления двух независимых событий равна произведению вероятностей этих событий. Р(АВ) = Р(А)*Р(В) или Р(А1,А2,…,Аn) = Р(А1)*Р(А2)*…*Р(Аn) Учитывая независимость событий и возможность появления двух событий одновременно тогда вероятность суммы двух независимых событий А и В более точно находят следующим образом: Р(А+В) = Р(А) + Р(В) – Р(АВ), где Р(АВ) – вероятность их одновременного появления 10. Условность событий Безусловные события рассматриваются вне конкретных условий и обозначаются просто буквами А,В,С и т.д. Условные события – рассматриваются при наступлении других событий. Они обозначаются например А/В – событие А при условии наступления события В и т.д. Условную вероятность события А при наступлении события В находят следующим образом: Р(А/В)=Р(АВ)/Р(В), если Р(В) ≠0 С помощью условных и безусловных вероятностей можно корректно определить зависимость или независимость событий. События А,В и С называют независимыми если их безусловные вероятности равны их условным вероятностям: Р(А)=Р(А/В)=Р(А/С)=Р(А/ВС) Р(В)=Р(В/А)=Р(В/С)=Р(В/АС) Р(С)=Р(С/А)=Р(С/В)=Р(С/АВ) Это так называемое условие независимости событий. Если это условие нарушается, то события зависимы. Чем больше различия, тем сильнее зависимость. Если рассмотреть вероятность совмещения (произведения) двух событий с учетом условности, то есть если принять что событие А наступает при условии наступления события В, то вероятность совмещения можно записать двумя способами: Р(АВ)=Р(А)*Р(В/А) Р(АВ)=Р(В)*Р(А/В) Если брать три события, то количество способов, которыми можно записать вероятность их совмещения возрастает до двенадцати и т.д. 11. Понятие случайной величины Случайная величина – величина, значение которой получается в результате пересчета или измерений и не может быть однозначно определено условиями его возникновения. То есть случайная величина представляет собой числовые случайные события. Случайные величины подразделяют на два класса: Дискретные случайные величины – значения этих величин представляют собой натуральные числа, которым как отдельным событиям сопоставляются частоты и вероятности. Непрерывные случайные величины – могут принимать любые значения из некоторого промежутка (интервала). Учитывая, что на промежутке от Х1 до Х2 числовых значений бесконечное множество, то вероятность того, что случайная величина ХiЄ(Х1,Х2) примет определенное значение, бесконечно мала. Учитывая, что невозможно перечислить все значения непрерывной случайной величины, на практике пользуются средним значением интервала (Х1,Х2). Для дискретных случайных величин функция у=Р(х) - называется функцией распределения случайной величины и имеет график – его называют многоугольник распределения. Различают следующие группы числовых характеристик: характеристики положения (математическое ожидание, мода, медиана, квантиль и др.), рассеивания (дисперсия, среднеквадратичное отклонение и др.), характеристики формы плотности распределения (показатель асимметрии, эксцесса и др.). Математическим ожиданием (средним значением по распределению) называется действительное число, определяемое в зависимости от типа СВ Х формулой: mX = M[X] = Математическое ожидание существует,

если ряд (соответственно интеграл) в правой части формулы сходится абсолютно.

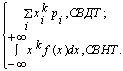

Если mX = 0, то СВ Х называется центрированной (обозначается Свойства математического ожидания: M[C] = C, где С - константа; M[C×X] = C×M[X]; M[X+Y] = M[X]+M[Y], для любых СВ X и Y; M[X×Y] = M[X]×M[Y] + KXY, где KXY = M[ Начальным моментом k-го порядка (k = 0, 1, 2, ...) распределения СВ Х называется действительное число, определяемое по формуле: nk = M[Xk] =

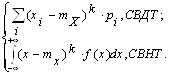

Центральным моментом k-го порядка распределения СВ Х называется число, определяемое по формуле: mk = M[(X-mX)k]= Из определений моментов, в частности, следует, что: n0 = m0 = 1, n1 = mX, m2 = DX = sX2. Модой СВНТ называется действительное число Mo(X) = x*, определяемое как точка максимума ПР f(x). Мода может иметь единственное значение (унимодальное распределение) или иметь множество значений (мультимодальное распределение). Медианой СВНТ называется действительное число Mе(X) = x0, удовлетворяющее условию: P{X < x0} = P{X ³ x0} или F(x0) = 0,5. Квантилем уровня р называется действительное число tp, удовлетворяющее уравнению: F(tp) = p. В частности, из определения медианы следует, что x0 = t0,5. Дисперсией СВ Х называется неотрицательное число D[X] = DХ, определяемое формулой: DX = M[(X-mX)2] = M[X2] - mX2 = Дисперсия существует, если ряд (соответственно интеграл) в правой части равенства сходится. Свойства дисперсии: D[C] = 0, где С - константа; D[C×X] = C2×D[X]; D[X-C] = D[X], дисперсия, очевидно, не меняется от смещения СВ X; D[X + Y] = D[X] + D[Y] + 2×KXY, где KXY = M[

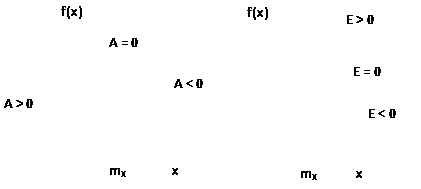

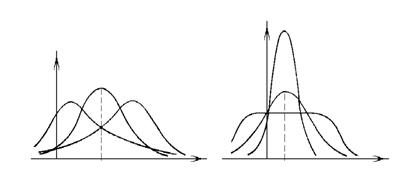

Неотрицательное число sХ = Показателем асимметрии ПР является коэффициент асимметрии (“скошенности”) распределения: A = m3/s3X. Показателем эксцесса ПР является коэффициент эксцесса (“островершинности”) распределения: E = (m4/s4X)-3. В частности, для нормального распределения E = 0.

Упорядочная совокупность n

случайных величин (СВ) Х1, Х2, ..., Хn, рассматриваемых совместно в

данном опыте, называется n-мерной СВ или случайным вектором и обозначается Функцией распределения (ФР) n-мерного случайного вектора называется функция n действительных переменных х1, x2, ..., xn, определяемая как вероятность совместного выполнения n неравенств: F(x1, x2, ... xn) = P{ X1 < x1, X2 < x2,..., Xn < xn}. В частности, для двумерного случайного вектора (X, Y) по определению ФР имеем: F(x, y) = P{X < x, Y < y}. ФР F (х, у) обладает следующими свойствами: 1. 0 £ F(x, у) £ 1; 2. F(x, у) - неубывающая функция своих аргументов; 3. 4. Свойство 4 обычно называют условием согласованности. Оно означает, что ФР отдельных компонент случайного вектора могут быть найдены предельным переходом из функции совместного распределения этих компонент. Вероятность попадания случайной точки на плоскости (X, Y) в прямоугольник со сторонами, параллельными осям координат, может быть вычислена с помощью ФР по формуле: P{x1 £ X < x2, y1 £ Y < y2} = F(x1, y1)+ F(x2, y2)- F(x1, y2)- F(x2, y1). Двумерный случайный вектор (X,Y)

называется случайным вектором дискретного типа (СВДТ), если множество его

возможных значений G(x, y) не более чем счетно. Ее закон распределения можно

задать двумерной таблицей из перечня возможных значений пар компонент (хi, yi) и

соответствующих каждой такой паре вероятностей pij = P{X = xi, Y = yj},

удовлетворяющих условию Двумерный случайный вектор (X, Y) называется случайным вектором непрерывного типа (СВНТ), если существует такая неотрицательная функция f(x, y) называемая плотностью распределения (ПР) вероятностей случайного вектора, что: f(x, y) = ПР вероятностей обладает следующими свойствами: f(x, y) ³ 0, (x, y) Î R2;

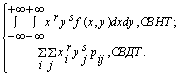

ПР вероятностей отдельных компонент случайного вектора выражаются в виде интегралов от совместной плотности: f(x) = Вероятность попадания случайной точки в произвольную квадрируемую область S на плоскости определяется по формуле P{(X, Y) Î S}= Условной плотностью распределения вероятностей случайной компоненты X при условии, что компонента Y приняла определенное значение у, называется функция f(x/y) действительной переменной х Î R: f(x/y) = f(x, y)/f(y). Аналогично определяется условная плотностью распределения вероятностей случайной компоненты Y при условии, что компонента X приняла определенное значение x: f(y/x) = f(x, y)/f(x). СВ X1, X2, ..., Хn называются независимыми (в совокупности), если для событий {Xi Î Bi}, i = 1, 2, ..., n, где B1, B2, ... Bn - подмножества числовой прямой, выполняется равенство: P{X1 Î B1, X2 Î B2, ... Xn Î Bn} = P{X1 Î B1}× P{X2 Î B2}× ... ×P{Xn Î Bn}. Теорема: СВ X1, Х2, .... Хn независимы тогда и только тогда, когда в любой точке x = (x1, x2, ..., xn) имеет место равенство: F(x1, x2, ..., xn) = F(x1) × F (x2) × ... × F (xn) (или f(x1, x2, ..., xn) = f(x1) × f(x2) × ... × f(xn)). Для двумерного случайного вектора (X, Y) вводятся следующие числовые характеристики. Начальным моментом порядка r + s случайного вектора (X, Y) называется действительное число nr,s, определяемое формулой: nr,s = M[Xr Ys] = Начальный момент nr,s существует, если интеграл (соответственно ряд) в правой части равенства абсолютно сходится. В частности, nr,0 = M[Xr] - соответствующие начальные моменты компоненты X. Вектор с неслучайными координатами (mX, mY) = (n1,0, n0,1) называется математическим ожиданием случайного вектора (X, Y) или центром рассеивания. Центральным моментом порядка r + s случайного вектора (X, Y) называется действительное число mr,s определяемое формулой mr,s = M[(X-mX)r (Y-mY)s] = Центральный момент mr,s существует, если интеграл (соответственно ряд) в правой части равенства абсолютно сходится. Вектор с неслучайными координатами (DX, DY) = (m2,0, m0,2) называется дисперсией случайного вектора. Центральный момент m1,1 называется корреляционным моментом (ковариацией): KXY =

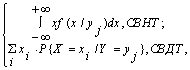

M[ Коэффициентом корреляции двух случайных компонентов X и Y случайного вектора является нормированная ковариация rXY = KXY/(sXsY). Свойства ковариации (и коэффициента корреляции): KXX = DX, KYY = DY, (rXX = rYY = 1); KXY = KYX, (rXY = rYX); |KXY| £ Ковариационный момент и коэффициент корреляции определяет степень линейной зависимости между X и Y. Условие |rXY | = 1 необходимо и достаточно, чтобы СВ X и Y были связаны линейной зависимостью Х = a×Y + b, где a и b - константы. СВ, для которых KXY = 0 (rXY = 0), называются некоррелированными. Из независимости случайных величин Х и Y вытекает их некоррелированность (обратное, вообще говоря, неверно). Условным математическим ожиданием компоненты Х при условии, что Y приняла одно из своих возможных значений yj, называется действительное число определяемое формулой: mX/Y = M[X/Y = yj] = где Р{X = xi /Y = yj} =

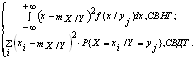

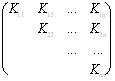

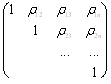

Условной дисперсией компоненты Х при условии, что Y приняла одно из своих возможных значений yj, называется действительное число определяемое формулой: DX/Y = D[X/Y = yj] = Приведенные выше формулы для числовых характеристик двумерного случайного вектора без труда обобщаются на случай n-мерного случайного вектора (Х1, Х2, ..., Хn). Так, например, вектор с неслучайными координатами (m1, m2, ..., mn), где mi - математическое ожидание СВ Хi, определяемое формулой mi = M[Xi] = называется центром, рассеивания случайного вектора. Ковариационной матрицей n-мерного

случайного вектора K

= где Кij

= M[ Очевидно, что Кii = М[Xi2] -дисперсия i-й компоненты. Корреляционной матрицей n-мерного случайного вектора называется симметрическая матрица, составленная из коэффициентов корреляции соответствующих пар компонент случайного вектора: C

= Заключение Таким образом, рассмотрев теорию вероятности, ее историю и положения и возможности, можно утверждать, что возникновение данной теории не было случайным явлением вы науке, а было вызвано необходимостью дальнейшего развития технологии и кибернетики, поскольку существующее программное управление не может помочь человеку в создании таких кибернетических машин, которые, подобно человеку, будут мыслить самостоятельно. И именно теория вероятности может способствовать появлению искусственного разума. «Процессы управления , где бы они ни протекали – живых организмах, машинах или обществе,- происходят по одним и тем же законам», - провозгласила кибернетика. А значит, и те, пусть еще не познанные до конца, процессы, что протекают в голове человека и позволяют ему гибко приспосабливаться к изменяющейся обстановке, можно воспроизвести искусственно в сложных автоматических устройствах. Важнейшим понятием математики является понятие функции, но почти всегда речь шла об однозначной функции, у которой одному значению аргумента соответствует только одно значение функции и функциональная связь между ними четко определенная. Однако в реальности происходят случайные явления, и многие события имеют не определенный характер связей. Поиск закономерностей в случайных явлениях - это задача раздела математики теория вероятности. Теория вероятности является инструментом для изучения скрытых и неоднозначных связей различных явлений во многих отраслях науки, техники и экономики. Теория вероятности позволяет достоверно вычислить колебания спроса, предложения, цен и других экономических показателей. Также теория вероятности является основой такой науки как статистика. На формулах этого раздела математики построено так называемая теория игр. 1. Беляев Ю.К. и Носко В.П. «Основные понятия и задачи математической статистики.» - М.: Изд-во МГУ, ЧеРо, 2006. 2. В.Е. Гмурман «Теория вероятностей и математическая статистика. - М.: Высшая школа, 1997. 3. Корн Г.,Корн Т. «Справочник по математике для научных работников и инженеров. - СПБ:Издательство “Лань” 2003. 4. Пехелецкий И. Д. «Математика учебник для студентов.» - М. Академия, 2003. 5. Суходольский В.Г. «Лекции по высшей математике для гуманитариев.» - СПБ Издательство Санкт - Петербургского государственного университета. 2003; 6. Гнеденко Б. В. и Хинчин А. Я. « Элементарное введение в теорию вероятностей» 3 изд., М. - Л., 1952. 7. Гнеденко Б. В. «Курс теории вероятностей» 4 изд., М., 1965. 8. Феллер В. « Введение в теорию вероятностей и её приложение» (Дискретные распределения), пер. с англ., 2 изд., т. 1-2, М., 1967. 9. Бернштейн С. Н. « Теория вероятностей» 4 изд., М. - Л., 1946 10. Для подготовки данной работы были использованы материалы с сайта http://med-lib.ru/ 11. Для подготовки данной работы были использованы материалы с сайта http://www.neuch.ru/ |

Страницы: 1, 2

,

,  , rij

=

, rij

=